IA, NEURONES ET INFOX

L’émergence d’une technologie reflète à la fois l’état d’esprit d’une époque et sa maturité technique. Elle est entretenue par une narration officielle que dessine les premiers ambassadeurs et la communauté de primo-adoptants. Il s’agit de retracer ici le plus fidèlement possible la chaîne d’événements qui a conduit à l’émergence des médias synthétiques pour mieux les comprendre.

❋

Il faut remonter tout droit vers le milieu de la Seconde Guerre mondiale, en 1943 pour trouver les prémices des hypertrucages. Walter Pitts, un logicien américain et Warren McCulloch, un chercheur en neurologie à l’origine de la cybernétique, publient A Logical Calculus of Ideas Immanent in Nervous Activity, dans lequel ils proposent un modèle mathématique permettant de combiner algorithmes et neurosciences pour répliquer le processus de pensée humain. Un modèle révolutionnaire pour l’époque, qui va mettre Alan Turing 1Alan Turing est un mathématicien et cryptologie britannique, auteur de travaux qui fondent scientifiquement l’informatique. Il a notamment aidé à décrypter la fameuse machine nazie « Enigma » qui servait à crypter les communications allemandes pendant la Seconde Guerre mondiale. sur la voie de l’apprentissage des machines et de l’intelligence artificielle.

Portrait d’Alan Turing à l’âge de 16 ans

Ce n’est qu’en 1965, après les travaux de Turing et Frank Rosenblatt qui posent les bases techniques du réseau de neurones, qu’Alexey Ivakhnenko crée le premier réseau d’apprentissage profond (Deep Learning Network 2Le « deep learning » fait partie d’une famille de méthodes d’apprentissage automatique fondées sur l’apprentissage de modèles de données.) et invente le GMDH (Group Method of Data Handling), une famille d’instructions algorithmique permettant d’analyser des données sur le modèle des réseaux de neurones biologiques. Ivakhnenko et son équipe parviennent à créer un réseau d’une profondeur de huit couches (en 2017, la profondeur était de 1 000 couches) et démontrent dans le même temps la capacité d’un ordinateur à « apprendre » automatiquement. Quelques progrès seront faits entre les années 1970 et 1990, dont la reconnaissance de récurrences visuelles en 1980 par le Neocognitron de Kunihilo Fukushima, mais c’est avec la montée en puissance des capacités de calcul des ordinateurs personnels au début des années 1990 que les choses commencent à rapidement évoluer.

Yann LeCun 3Yann Le Cun est un chercheur français en intelligence artificielle et vision artificielle. Il est considéré comme l’un des inventeurs de l’apprentissage profond et travaille désormais pour Facebook., Christopher Watkins et d’autres vont alors grandement contribuer au développement de ce qu’on appelle communément l’intelligence artificielle. En 2012, le concours de reconnaissance d’images organisé par ImageNet 4imagenet est une base de données regroupant des millions d’images à classer par catégories destinées à l’entraînement des réseaux neuronaux profonds est remporté pour la première fois avec un réseau neuronal profond.

C’est la renaissance du Deep Learning.

❋

En 2014, deux innovations dans le domaine de l’intelligence artificielle et des réseaux de neurones permettant l’avènement des deepfakes bouleversent le monde de l’apprentissage profond.

La première se nomme Deepface. Développé par Facebook sous la supervision de Yann Lecun, le système utilise les réseaux neuronaux pour identifier les visages avec une précision de 97,35 %. Le saut qualitatif est gigantesque puisqu’il représente une amélioration de performances de 27 % par rapport à la précédente solution et rapproche la machine de l’humain.

La seconde innovation, les réseaux antagonistes génératifs (en anglais Generative Adversarial Networks ou GAN), nous vient de Ian Goodfellow, un chercheur en intelligence artificielle (I.A) américain employé par Google Brain, la branche d’Alphabet (maison mère de Google) en charge des recherches sur l’intelligence artificielle.

Ces GANs sont des algorithmes d’apprentissage « non supervisés » qui permettent de créer des images extrêmement réalistes. C’est leur autonomie de fonctionnement qui les distingue des autres types d’algorithmes. Les GANs reposent sur deux réseaux qui sont placés en compétition l’un avec l’autre. Le premier va générer un certain nombre d’échantillons à partir d’une base de données, c’est le « générateur ». Le second reçoit des échantillons réels et fabriqués et tente de déterminer s’ils sont issus du générateur ou s’il s’agit de véritables échantillons, c’est le discriminateur. Sans eux, pas de deepfake. Les résultats sont prometteurs et peu à peu suscitent l’intérêt d’autres chercheurs désireux de réaliser des applications pour l’industrie cinématographique.

En 2016, un groupe de cinq chercheurs appartenant à l’université Erlangen-Nuremberg, au Max-Planck-Institute for Informatics et à l’université de Stanford, publient Face2Face : Real-Time Face Capture and Reenactment of RGB Videos, dans lequel ils détaillent leurs travaux sur la manipulation d’images vidéo en temps réel.

Au cœur de leur travail, la possibilité de transférer les expressions du visage d’une personne, un acteur par exemple, sur un avatar numérique créé en temps réel. Les exemples associés à la publication sont saisissants. On y voit des vidéos de Daniel Craig et d’Arnold Schwarzenegger, de Georges W. Bush et de Donald Trump dont les expressions du visage sont calquées artificiellement sur les mouvements du visage des chercheurs testant leur solution.

La même année, les studios Disney sortent Rogue One, épisode prequel de la franchise Star Wars, dans lequel apparaissent une jeune Carrie Fisher et un Peter Cushing ressuscité (l’acteur est mort en 1994), dont les visages ont été entièrement recréés par ordinateur à l’aide d’un procédé de capture du mouvement très perfectionné. Si le résultat a suscité de vives réactions de la part de la communauté, ce n’est pas à cause du réalisme des captures qui, trop rigides, ne transmettaient pas l’essence du jeu des acteurs, mais plutôt pour des raisons éthiques. En comparaison, le résultat obtenu par le groupe de cinq chercheurs avec un investissement considérablement moins important a provoqué l’incrédulité de nombre d’observateurs.

La séquence du prequel de Starwars « Rogue One » (2016) mettant en scène une Carrie Fisher plus jeune que dans la vraie vie a été retouchée et comparée à la création des studios.

La même année, Adobe dévoile lors de son Adobe Max Creativity Conference le projet « VoCo » capable de reproduire fidèlement à partir d’un échantillon de 20 minutes la voix de n’importe quel individu, et Adobe Senseï, l’intelligence artificielle associée au logiciel de retouche d’images Photoshop. La puissance de l’intelligence des réseaux de neurones montre ici tout son potentiel pour l’industrie créative et préfigure déjà des évolutions à venir dans ce secteur.

Quelques mois plus tard, en 2017, trois chercheurs de l’université de Washington publient Synthesizing Obama : Learning Lip Sync from audio, un papier dans lequel ils décrivent leur méthodologie pour synchroniser une piste audio A à une vidéo B tout en faisant en sorte que les mouvements labiaux de la vidéo B collent aux mots prononcés dans la piste audio A. Une fois encore le résultat donne matière à réflexion tant il est impressionnant. Le président Obama tient un discours qu’il n’a jamais tenu dans ces circonstances ni dans le lieu où il se trouve. L’illusion est parfaite et la production d’une telle vidéo n’a finalement couté que peu d’efforts quand, une dizaine d’années auparavant, il aurait fallu une armée de techniciens de l’image pour aboutir à un tel résultat.

En novembre de la même année, tout bascule. Sur le réseau social Reddit, où se retrouvent les communautés de gamers, les geeks et autres dépositaires de la sous-culture pop véhiculée par le Web, un utilisateur anonyme agissant sous le pseudonyme « u/deepfake » crée le sous-groupe (subreddit) r/deepfake. Dans ce groupe, il partage des vidéos pornographiques dans lesquelles le visage des actrices X a été remplacé par celui de célébrités issues du cinéma hollywoodien. La méthode employée pour réaliser ces manipulations repose très clairement sur le deep learning ainsi que l’indiquent certaines archives retrouvées sur Github et anonfile. Celles-ci montrent que u/deepfake a téléversé sur le réseau un fichier compressé relativement modeste comprenant 17,6 Mo d’images de référence de Donald Trump et Nicolas Cage (déjà connu dans cette communauté pour être un sujet favori de création de mèmes 5Un mème est un terme inventé par Richard Dawkins dans son « Gène égoïste » (1976). Il s’agit d’un bout de culture pop qui se propage sur internet principalement sous la forme d’une image ou d’une vidéo. Le même utilise des visages populaires pour les mettre en scène de façon extravagante. Nicolas Cage, Rick Astley ou Donald Trump sont des figures très utilisées. )  ainsi que 398 lignes de code écrites en python réparties dans sept fichiers différents, dont presque la moitié (170) font appel à des librairies d’apprentissage profond (deep learning) en libre accès telles que Keras et TensorFlow, mises à disposition par Google. L’ensemble repose sur des algorithmes proches de ceux présentés par le fabricant de cartes graphiques Nvidia à la « Conference on Neural Information Processing Systems » en 2017.

ainsi que 398 lignes de code écrites en python réparties dans sept fichiers différents, dont presque la moitié (170) font appel à des librairies d’apprentissage profond (deep learning) en libre accès telles que Keras et TensorFlow, mises à disposition par Google. L’ensemble repose sur des algorithmes proches de ceux présentés par le fabricant de cartes graphiques Nvidia à la « Conference on Neural Information Processing Systems » en 2017.

Rapidement, le phénomène prend de l’ampleur et dès le mois de décembre 2017, les premiers articles apparaissent dans la presse spécialisée et grand public, notamment dans les colonnes du New York Times, du Washington Post, du Guardian, de Motherboard, de Wired, du Times et sur la BBC. Les articles ainsi recensés s’inquiètent du phénomène encore presque exclusivement centré sur la fabrication de courtes séquences pornographiques. Les auteurs y évoquent que les actrices Gal Gadot, Maisie Williams, Aubrey Plaza, Scarlett Johansson, Taylor Swift et Daisy Ridley, victimes de cette première vague. Au fil des semaines, le phénomène semble gagner en popularité.

Le 2 février 2018, quelques jours avant d’être définitivement banni de Reddit, le groupe r/deepfake compte 88 158 lecteurs, mais l’engouement semble fort puisqu’en suivant un lien depuis la page archivée par archive.is on découvre une page datant du 7 février 2018 où le nombre de lecteurs passe à 91 313 lecteurs soit une augmentation de 3155 lecteurs en cinq jours (une moyenne de croissance de près de 600 lecteurs/jours). D’autres communautés se forment ailleurs sur le Web. Deepfake.cc compte au 12 février 2018 un total de 6391 membres avant sa fermeture quelques semaines plus tard. Mr Deepfake, communauté encore active, compte au 16 mars 20 192 234 membres (soit 1830 membres gagnés depuis le dernier relevé en date du 3 mars 2019, moyenne de croissance de 140 membres/jour). GifFakes sur Reddit compte encore un total de 10 252 membres inscrits.

Difficile d’évaluer avec certitude la taille réelle de la communauté, les doublons de profils, les groupes bannis et les reports sur des groupes plus larges n’aident pas à une juste estimation, cependant on peut estimer qu’un minimum de 90 à 100 000 personnes a été exposé et/ou ont prit part à la fabrication de deepfakes à travers ces groupes, ce qui constitue un nombre conséquent d’individus en état de comprendre les techniques employées et capables de les utiliser.

Dans la même période, entre janvier et février 2018, les plateformes Discord, Gfycat, et les sites Pornhub 6Pornhub est un site pornographique canadien qui diffuse des vidéos pornographiques gratuitement. En 2019, le site se place à la 28e place des sites les plus visités au monde, à 4 places de Netflix. et Twitter bannissent les deepfakes, quand d’autres tentent de prospérer sur cette nouvelle mode et ouvrent des sites dédiés aux deepfakes pornographiques.

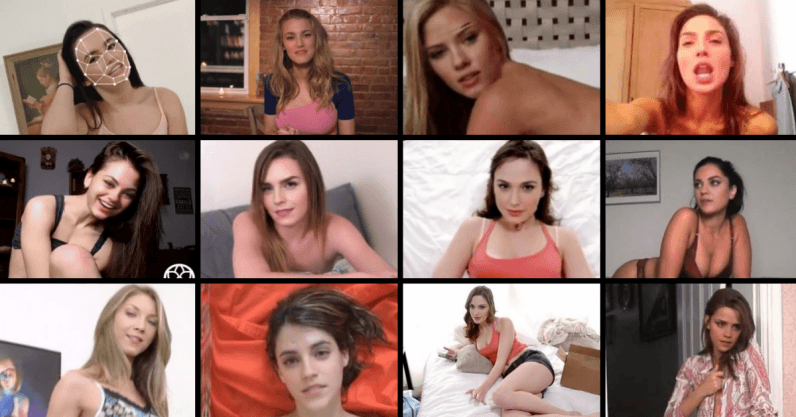

Une capture des deep-porns présents sur différentes plateformes mettant en scène des actrices sur lesquelles un faceswap de Gal Gadot (Wonderwoman) Daisy Ridley (Starwars) ou Emma Watson (Harry Potter).

Loin d’avoir éradiqué le phénomène, ces actions de contingence ont éveillé la curiosité de nombreux médias, exposant du même coup le grand public à ce phénomène nouveau. Un rapport de la société Deeptrace publié fin 2019 indique que le nombre de recherches pour le terme « deepfake » sur Google a connu une forte croissance entre novembre 2017 et novembre 2018. Le nombre de requêtes a explosé de moins de 200 000 à près de 500 000 entre mai 2018 et novembre 2018. Un dispositif de recherche développé par un développeur du journal Libération pour les besoins de ce mémoire a permis de récolter des données entre janvier et mars 2019 et elles confirment la tendance à la hausse du nombre d’articles écrits sur le sujet en anglais et en français.

Le même rapport publié par Deeptrace se penche sur la taille de la communauté de développeurs travaillant sur les projets en libre accès permettant de créer des deepfakes. Là aussi, le constat est sans appel puisqu’on constate une croissance constante du nombre de « commits » 7une modification du code validé par la communauté en vue d’en améliorer la performance ou d’y ajouter des fonctionnalités. En décembre 2018, le rapport indique pour le répertoire git deepfakes/faceswap un nombre de « stars » (personnes suivant le git) à 7728 et un nombre de « forks » (versions créées) de 2307. À la mi-mars 2019, le nombre de « stars » pour le même répertoire monte à près de 16 103 et le nombre de « fork » s’élève à 5373. La seule période de février 2019 totalise 69 commits contre 22 en janvier, 23 en décembre 2018 et 20 en novembre 2018.

La communauté autour des deepfakes est désormais comparable à celle de facebookresearch/detectron (19 502 stars et 4081 forks, chiffre relevé au 16 mars 2019). Les tendances sont les mêmes lorsqu’on observe le nombre de publication sur les Réseaux antagonistes génératifs ou « GAN ». En 2016, on en comptait à peine une cinquantaine, en 2017 presque 500 et en 2018 près de 900. Par contraste, seules 25 publications dans le monde portaient en 2018 sur les contre-mesures anti-deepfakes.

La récente évolution du modèle First Order Motion 8“First Order Motion Model for Image Animation” par Aliaksandr Siarohin, Stéphane Lathuilière, Sergey Tulyakov, Elisa Ricci and Nicu Sebe, 2019 permettant de reproduire des animations compte près de 540 branches différentes et l’intérêt qu’il suscite ne cesse de grandir.

Rien n’indique donc à ce stade que l’engouement pour ces nouvelles techniques retombe au contraire, tous les indicateurs suggèrent qu’une accélération de la croissance et de l’activité des communautés de développeurs.

Notes :

| ↑1 | Alan Turing est un mathématicien et cryptologie britannique, auteur de travaux qui fondent scientifiquement l’informatique. Il a notamment aidé à décrypter la fameuse machine nazie « Enigma » qui servait à crypter les communications allemandes pendant la Seconde Guerre mondiale. |

|---|---|

| ↑2 | Le « deep learning » fait partie d’une famille de méthodes d’apprentissage automatique fondées sur l’apprentissage de modèles de données. |

| ↑3 | Yann Le Cun est un chercheur français en intelligence artificielle et vision artificielle. Il est considéré comme l’un des inventeurs de l’apprentissage profond et travaille désormais pour Facebook. |

| ↑4 | imagenet est une base de données regroupant des millions d’images à classer par catégories destinées à l’entraînement des réseaux neuronaux profonds |

| ↑5 | Un mème est un terme inventé par Richard Dawkins dans son « Gène égoïste » (1976). Il s’agit d’un bout de culture pop qui se propage sur internet principalement sous la forme d’une image ou d’une vidéo. Le même utilise des visages populaires pour les mettre en scène de façon extravagante. Nicolas Cage, Rick Astley ou Donald Trump sont des figures très utilisées. |

| ↑6 | Pornhub est un site pornographique canadien qui diffuse des vidéos pornographiques gratuitement. En 2019, le site se place à la 28e place des sites les plus visités au monde, à 4 places de Netflix. |

| ↑7 | une modification du code validé par la communauté en vue d’en améliorer la performance ou d’y ajouter des fonctionnalités |

| ↑8 | “First Order Motion Model for Image Animation” par Aliaksandr Siarohin, Stéphane Lathuilière, Sergey Tulyakov, Elisa Ricci and Nicu Sebe, 2019 |