Les IA génératives envahissent notre espace numérique et si pour certains les outils de génération d’images comme Stable Diffusion ou Midjourney semblent porter les promesses d’une créativité illimitée, il faut s’assurer que l’outil ne comporte pas de défauts problématiques avant de l’intégrer au flux de travail quotidien.

▾

Depuis sa sortie mi 2022, Midjourney a évolué de façon spectaculaire, passant de résultats approximatifs à des résultats photoréalistes extrêmement impressionnants en l’espace de quelques mois. La qualité graphique s’améliore donc et les résultats sont désormais aussi bons (il faut bien l’admettre) que ce que pourraient produire des designers ou des photographes professionnels. Ces résultats reposent sur l’amélioration constante de l’algorithme de rendu, mais aussi de la base de données d’entrainement sur laquelle repose Midjourney. Et cette base, semble être frappée d’un défaut majeur : elle est biaisée.

Qu’est-ce qu’un biais ?

Qu’est-ce qu’un biais me direz-vous ? Eh bien c’est une erreur systématique que le modèle va reproduire à cause d’un défaut dans sa base de données. Cette erreur vient du fait qu’une donnée est manquante ou sous-représentée et que sa pondération dans le résultat final fourni par le modèle sera significativement inférieure aux autres données.

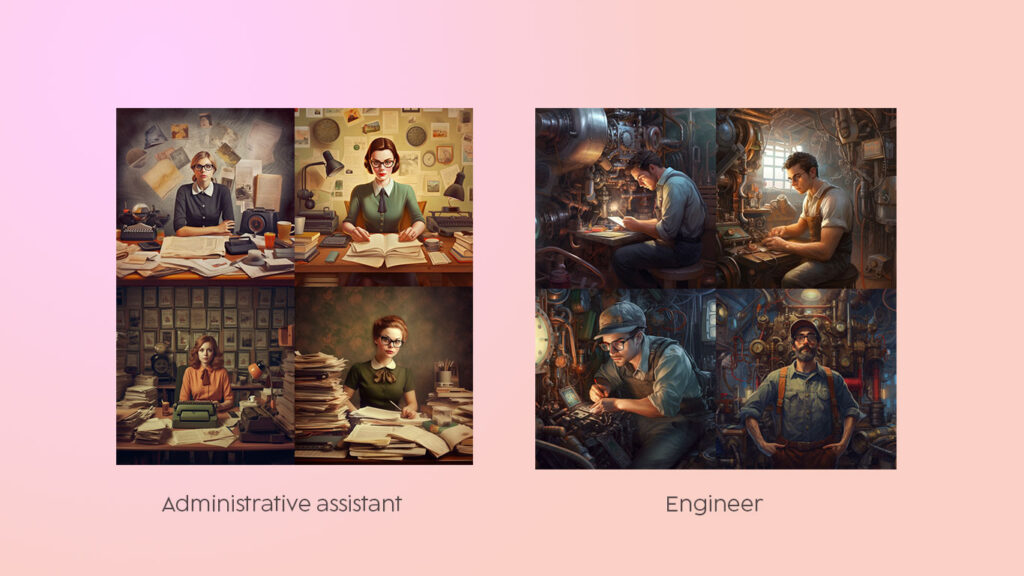

D’un côté les femmes assignées à des métiers d’assistance, de l’autre les hommes à des métiers de pouvoir, de contrôle et de technique.

Midjourney a été entraîné sur des échantillons de millions d’images existantes sur le Net, y compris des œuvres d’art provenant de diverses sources, des créations de designers, des photographies de stock, et ce, afin de générer de nouvelles images. Le modèle reflète ce qui existe en ligne, c’est une représentation du monde tel qu’il existe sur internet. Plus précisément, c’est une représentation du monde vu de notre bulle occidentale. La Chine par exemple, qui travaille sur les mêmes outils que ce dont nous disposons, dispose d’une représentation davantage centrée sur sa sphère culturelle et donc, davantage susceptible de reproduire les biais déjà présents dans sa culture. Et bien que les sociétés patriarcales soient légion dans le monde, la relation à l’autre, aux populations immigrées ou aux minorités par exemple, est toutes autres.

Donc, notre monde sur internet est principalement dominé par des puissances occidentales dont les codes visuels, les styles et l’iconographie sont majoritairement représentés. Midjourney est un miroir de cette culture, majoritairement blanche et masculine, et perpétue les clichés présents dans nos sociétés et nos cultures et qui se sont « naturellement » transposés en ligne.

Pour en avoir le cœur net, j’ai donc procédé à ma propre expérience de biais. Pour ce faire j’ai listé un certain nombre de professions les plus répandues, ainsi qu’un certain nombre de clichés attendus, et je les ai passé à la moulinette de Midjourney v.5 en utilisant un prompt simplissime comme celui-ci:

/imagine a [occupation].

L’expérience

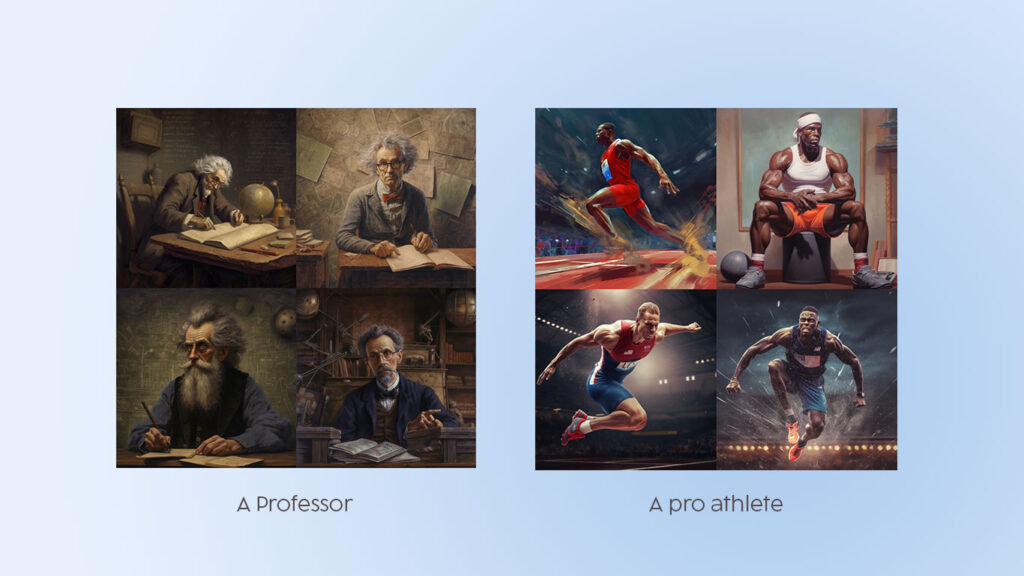

Les résultats sont conformes à ce que j’attendais, à savoir une surreprésentation des hommes blancs et une sous-représentation (massive) des femmes noires. Le cantonnement des hommes noirs, asiatiques et hispaniques à des professions manuelles et la domination des individus blancs dans la quasi-totalité des professions testées. La perpétuation de clichés racistes comme par exemple, les afro-américains en tant que sportifs, ou rappeurs, mais pas en tant que musiciens qui sont majoritairement des hommes blancs. Les CEO sont des hommes, impossible d’y voir une femme.

Les professeurs sont blancs, mais les athlètes de haut niveau sont noirs.

Certains traits de caractères ou de représentations ont également été testés en demandant à Midjourney par exemple d’imaginer la personne la plus riche au monde, la plus sensible ou la plus détestée. Les résultats montrent une fois de plus principalement des hommes blancs et invisibilisent les femmes et les minorités au sein des sociétés occidentales. En queue de peloton, les moins représentés, on retrouve les femmes asiatiques et les femmes noires qui disparaissent quasiment des propositions.

Quels enseignements ?

Difficile de savoir si les créateurs de Midjourney ont conscience de cette dérive. Le nombre d’articles sur le sujet laisse à penser que c’est le cas et on peut imaginer que les équipes prendront en compte cette problématique de représentation, sinon pour des raisons éthiques, au moins pour de simples raisons commerciales. Nous ne sommes plus au début du 20e siècle, certaines choses ne passent plus dans la société. Il ne s’agirait pas de reproduire l’erreur de Kodak avec ses pellicules. Reste qu’il faut maintenir une certaine vigilance et alerter aussi souvent que possible sur ces biais de représentation qui, s’ils sont petit à petit corrigés, participeront à une meilleure inclusion de tous dans nos sociétés.

Vous pouvez retrouver les tests effectués ci dessous par professions. J’alimenterai certainement ce tableau avec d’autres entrées pour le rendre plus complet.